Schwächen und Risiken

Einerseits können KI-basierte Programme Probleme lösen und den Menschen vielfach helfen, beispielsweise in der medizinischen Diagnostik. Doch ebenso birgt die Technologie zahlreiche Risiken. Um KI-Systeme kompetent einzusetzen, müssen wir uns dieser Gefahren und Probleme bewusst sein. Dabei gilt es zwei Punkte zu unterscheiden. Einerseits gibt es Probleme, die KI-Systemen inhärent sind. Diese sind keine Absicht von Herstellerinnen und Hersteller oder Anwenderinnen und Anwender. Dazu zählen Halluzinationen von Sprachmodellen, da sie auf Wahrscheinlichkeiten beruhen und somit immer auch eine zufällige Komponente beinhalten. Auf der anderen Seite können KI-gestützte Programme missbraucht werden, um Menschen zu manipulieren oder gezielt zu täuschen (externes Risiko). So wird zum Beispiel die Erstellung und Verbreitung von (politischer) Desinformation deutlich erleichtert. Je mehr wir uns der inhärenten als auch der externen Risiken bewusst sind, desto besser können wir KI-Systeme regulieren und sinnvoll und ethisch vertretbar einsetzen.

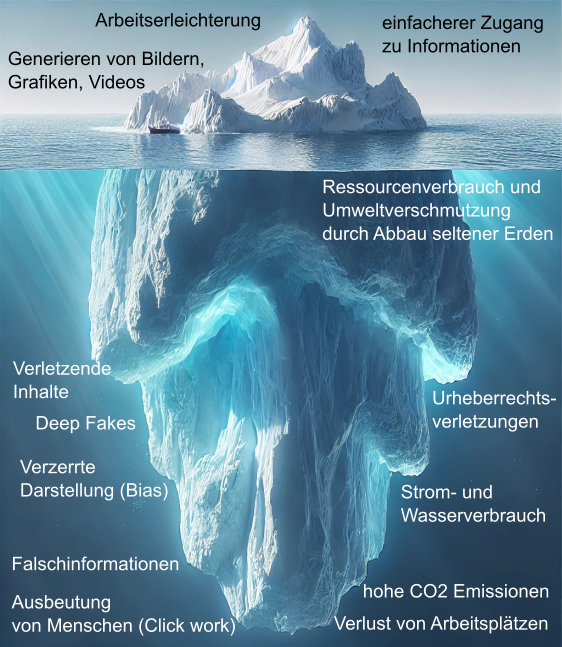

Die Chancen, die KI-bietet, sind vielfältig und häufig bekannt, doch es gibt auch versteckte Kosten und Risiken, wie es das Eisbergmodell von Luccioni darstellt.

Die versteckten Kosten der KI nach Luccioni, erstellt mithilfe von DALL-E3 (2.2.2025) Zeichne mir einen Eisberg im Wasser, der größte Teil ist unter Wasser zu sehen.

[gemeinfrei]

Im Weiteren werden einige dieser Risiken analysiert.

Diskriminierung und Bias

Wie im Abschnitt zu den Grundprinzipien des maschinellen Lernens erklärt, sind die Trainingsdaten ein wesentlicher Faktor, der über die Funktionsweise eines KI-Systems entscheidet. Sind diese unvollständig oder voreingenommen, so kann dies dazu führen, dass KI-Algorithmen diskriminierende Entscheidungen treffen, beispielsweise bei der Kreditvergabe oder der Einstellung von Mitarbeiterinnen und Mitarbeiter. Ein Beispiel dafür ist die geringere Genauigkeit von Gesichtserkennungssystemen bei Schwarzen Menschen, da in den Trainingsdaten häufig überwiegend weiße Personen repräsentiert sind. Diese Verzerrung kann soweit gehen, dass Schwarze Menschen als Affen klassifiziert werden, wie es 2015 bei einer Foto-App von Google der Fall war (Spiegel Artikel). Eine weitere Folge ist, dass Schwarze Menschen schlechter unterschieden werden können. Im Jahr 2023 wurde deshalb eine hochschwangere Frau zu Unrecht eines Autoraubs verdächtigt, weil die Gesichtserkennungssoftware sie verwechselte, im Tagesanzeiger dazu mehr.

Über die dunklen Seiten von KI finden Sie auf te.ma einen empfehlenswerten Artikel.

Es wäre einfach zu sagen, dass die KI

allein für dieses diskriminierende Verhalten verantwortlich sei. Doch macht sie nur Macht- und Denkstrukturen der Menschheit und insbesondere der für das KI-System verantwortlichen Personen deutlich. Alle Menschen, so auch die Entwicklerinnen und Entwickler von KI-Systemen, unterliegen unbewussten Vorurteilen (Bias). Hier kommt noch zum Tragen, dass KI-Systeme insbesondere von weißen Männern entwickelt werden und somit Perspektiven von Frauen oder POCs häufig fehlen. Das zeigt sich beispielsweise, wenn man eine Übersetzungsapp nutzt und the doctor who

und the nurse who

übersetzen lässt. Dabei wird the doctor who

(obwohl im Englischen neutral) im Deutschen zu Der Arzt, der

und the nurse who

zu einer Frau also Die Krankenschwester, die

.

Ähnlich vorurteilsbeladen sieht es mit der meist heteronormativen Darstellung von Paaren aus oder dem sehr häufig als männlich und weiß dargestellten Manager

. Das ist übrigens auch bei einer Google-Bilder-Suche der Fall. Ebenfalls lassen sich einige Vorurteile erkennen, wenn man ein Bild einer deutsche Familien beim Essen generieren lässt. Das rustikale Ambiente verweist auf eine bekannte Gleichsetzung von Bayern (oder anderen Gegenden im Süddeutschen Raum) und Deutschland. Auf dem Tisch gibt es Würste, seltsames Brot und Kartoffeln. Und ist in den Gläsern abgestandenes Bier oder Apfelsaft? Zumindest ein hölzerner Bierhumpen steht mit drauf. Und was bedeuten die Uhren an vielen der Wänden?

Bias in der Bildgenerierung, erstellt mit DALL-E3 (2.2.2025), Prompts jeweils in den Überschriften [gemeinfrei]

Auf der anderen Seite wird kein Trainingsdatensatz alle Fälle des realen Lebens abdecken können, sodass selbst bei einer möglichst fairen Basis, die Daten unvollständig und somit diskriminierend sein können. Mittlerweile versuchen viele KI-Anwendungen nachzubessern, damit Ausgaben diverser sind. Das kann teilweise wiederum zu absurden Darstellungen von Schwarzen Päpstinnen oder asiatischen Wehrmachtssoldaten führen. Über die Diversität bei der Google KI geht es in diesem Artikel auf ZEIT online.

Ein interessanter Test, der demonstriert, welche Verallgemeinerungen KI-Anwendungen nutzen, um Menschen zu bewerten, ist auf der Website How Normal Am I? zu finden.

Postkoloniale Strukturen

Die meisten KI-gestützten Systeme sind von Menschen aus dem Globalen Norden für Menschen im Globalen Norden gemacht. Das erkennt man beispielsweise auch daran, dass diese auf englisch deutlich besser funktionieren als auf anderen Sprachen, die im Globalen Süden vertreten sind. Das liegt natürlich auch daran, dass diese im Netz trotz einer großen Anzahl an Muttersprachlerinnen und Muttersprachlern kaum vertreten sind. Mehr dazu wie Menschen im Globalen Süden von KI-Systemen ignoriert werden, kann in einem Artikel von Der Standard nachgelesen werden.

Menschen im Globalen Süden sind nicht nur weniger gut in den Trainingsdaten der KI-Systeme repräsentiert, sondern dort werden sowohl Menschen als auch Natur aufgrund bestehender postkolonialer Machtstrukturen ausgebeutet. Bezogen auf KI-Systeme heißt das im Detail:

Ausbeutung von Menschen

Alle KI-Modelle aus dem Bereich des überwachten Lernens sind auf eine große Menge an gelabelten Daten angewiesen. In einer der weitverbreitetsten Datenbanken für Bilder, ImageNet, sind mehr als 14 Millionen gelabelte (also beschriftete) Bilder enthalten. Zur Erstellung einer solch großen Datensammlung werden Menschen gebraucht, die Bilder klassifizieren und sie dann in die Datenbank ablegen. Als billige Arbeitskräfte dienen hier oft Menschen aus dem Globalen Süden - sogenannte Click Worker

. Diese Leute werden nicht nur schlecht bezahlt, sondern auch über die teilweise traumatisierenden Inhalte weder aufgeklärt noch anschließend adäquat betreut.

Für Interessierte findet sich näheres dazu in einer Podcastfolge des SWR zum Thema Click-Worker

(Dauer 30 Min.).

Neben dem Labeling wird auch das Beta-Testing vieler KI-Modelle in den Globalen Süden ausgelagert. Dabei werden persönliche Daten der Nutzerinnen und Nutzer gesammelt, jedoch gleichzeitig Art und Umfang des Zugangs zu neuen Technologien kontrolliert, und über die Nutzung der Daten nicht aufgeklärt. Ein sehr ausführlicher Beitrag ist in einem Sammelbad des Rhet AI Centers erschienen.

Ausbeutung der Natur

Doch nicht nur Menschen, sondern auch die Natur im Globalen Süden wird ausgebeutet. Der Abbau von seltenen Erden für die Rechen- und Speicherkapazitäten von KI-Anwendungen ist auf te.ma ein Beispiel.

|

Aufgabe: Schauen Sie das folgende Video an von Dr. Anne Burkhardt, Wissenschaftlerin der Uni Tübingen. Sie geht in folgendem Video (Youtube) genauer auf die postkolonialen Strukturen und ethischen Themen ein, die mit den KI-Systemen einhergehen. Beantworten Sie anschließend das Quiz |

Hier ist der Link zu der interaktiven Karte, die in Anne Burkhardts Video gezeigt wurde, um das Machtgefüge des Internets zu visualisieren.

Energieverbrauch

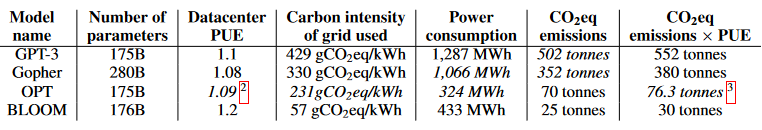

Neuronale Netze zu trainieren als auch zu nutzen, ist energieintensiv. Das kann einen großen CO2-Fußabdruck verursachen, der abhängig ist von der Hardware, der Software und den Datenmengen als auch vom Anteil an erneuerbaren Energien im Strommix, der genutzt wird. Wenn man bedenkt, mit welcher Geschwindigkeit immer mehr KI-Systeme auf den Markt kommen, dann summieren sich hier entstehenden CO2-Mengen zu einer Größenordnung, die relevant ist für den Klimawandel. In einem Paper aus dem Jahr 2022 werden folgende Werte für das Training angegeben:

CO2 Emission unterschiedlicher Modelle aus Luiccioni et al. 2022, Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model Quelle CC-BY 4.0

In dieser Liste stehen neben GPT-3 (das damalige Sprachmodell von ChatGPT; heute ist es GPT-4) noch drei weitere Sprachmodelle. Gopher, OPT und BLOOM sind weniger bekannt. Dabei achten die Entwicklerinnen und Entwickler von BLOOM auf einen möglichst geringen CO2-Fußabdruck. Außerdem ist es auf huggingface.com frei verfügbar, muss aber installiert werden. Dadurch ist es für Laien nicht so einfach nutzbar.

Zurück zum Energieverbrauch und den Emissionen: Bereits für das Training von GPT-3 wurden 552 Tonnen CO2-Äquivalente erzeugt. Zum Vergleich: Die durchschnittlichen Treibhausemissionen eines Deutschen lagen 2016 bei mehr als 11 Tonnen CO2-Äquivalenten im Jahr, was weit mehr ist als empfohlen (Quelle Bundesumweltamt). Doch nicht nur für das Training des Modells, auch bei der Nutzung von KI-gestützten Systemen wird Strom verbraucht und damit CO2 emittiert. Rechenzentren und Datenübermittlung machen 2-4 % der weltweiten CO2-Emissionen aus, davon ist natürlich nur ein Teil auf KI-Systeme zurückzuführen. Da immer mehr KI-gestützte Tools entwickelt und genutzt werden, steigt der Anteil, aber auch die Gesamtmenge der Emissionen durch KI. Es wird geschätzt, dass die Nutzung von GPT-2 allein im Februar 2023 insgesamt 244 000 Tonnen CO2-Äquivalente verursacht hat. Für leistungsfähigere Systeme wie GPT-4 werden die Werte sicher noch höher sein (Quelle: Süddeutsche Zeitung). Man nimmt an, dass eine ChatGPT-Anfrage allein ca. 6,8 Wh Energie verbraucht, während es für eine Google-Abfrage nur 0,3 Wh sind (Quelle: Süddeutsche Zeitung). Zum Vergleich: Um eine Tasse Wasser (200 ml) zum Kochen zu bringen, werden ca. 18,7 Wh Energie benötigt.

Hier finden sie noch mehr Informationen zum Fußabdruck (te.ma Artikel), zu Folgen für den Klimawandel (dw Artikel) oder zum Wasserverbrauch (FAZ Artikel).

Manipulation

Content Generierung

KI-basierte Tools haben mittlerweile enorme Fähigkeiten erworben, menschliche Sprache zu imitieren und in kürzester Zeit sowohl glaubwürdige Texte als auch Bilder und in Zukunft sicher auch immer bessere Videos zu generieren. So können verstorbene Personen wieder auferstehen, wie beispielsweise der 1955 verstobene Schauspieler James Dean, der in dem Film Finding Jack

mithilfe von KI-gestützter Videoproduktion wiederbelebt werden soll. Oder Carrie Fisher, die nach ihrem Tod in Star Wars: Episode IX – The Rise of Skywalker

digital als Prinzessin Leia eingefügt wurde. Dazu gibt es auf der Website Watson.ch ein Interview zum Thema für Interessierte.

Die Möglichkeiten automatische Inhalte zu generieren, erlauben jedoch auch großflächig Fehlinformationen zu verbreiten. Sogenannte Fake News oder Deep Fakes können Meinungen manipulieren und damit Wahlen beeinflussen oder auch Menschen gezielt schädigen, wie zum Beispiel in Deep Fake Pornografie. Hier ein Beispiel für die erschreckenden Fähigkeiten von KI im Fake Bereich: eine Reportage zu Deepfake-Pornos (ARD-Mediathek).

Bei der Erstellung von gefälschten Bildern oder Videos unterscheidet man zwischen drei Formen von Deep Fakes:

- Erstens können mit KI-Technologien Gesichter auf vorhandenem Material getauscht werden, sogenannte Face-Swaps. Dieses kurze Video (Youtube) zeigt, wie das funktioniert.

- Außerdem kann die Stimme einer Person mithilfe kurzer Sprachaufnahmen rekonstruiert werden und ihr somit neue Texte in den Mund gelegt werden. Das gelingt sogar für verschiedene Sprachen unter Beibehaltung der eigenen Sprachmelodie. Ein Beispiel von HeyGen ist auf Youtubezu sehen und hören.

- Drittens können gesamte Bewegungsabläufe von einer Person auf eine andere übertragen werden.

Um die potenziellen Fehlinformationen identifizieren zu können, ist es zentral, Bewusstsein dafür zu schaffen, dass Informationen gefälscht sein können und hier einerseits auf die Quellen der Informationen zu achten und andererseits geschult zu sein in den typischen Mustern von KI-generiertem Material. In Selbstlernkurs auf genial.ly (Dauer 30 Min) gibt es weiteres Hintergrundwissen zu Deep Fakes, sowie ein Expertinnen-Interview und einen Selbsttest, wie kompetent man gefälschte Informationen erkennen kann.

Der Bayrische Rundfunk hat eine Unterrichtsstunde zu dem Thema entwickelt.

Vorschläge

Eine weitere Einsatzmöglichkeit von KI-Systemen sind automatische Vorschläge für Inhalte in sozialen Medien oder bei Streamingdiensten. Algorithmen analysieren die bereits angeschauten oder gehörten Inhalte, um neue Vorschläge zu erstellen. Was für Streamingdienste wie Netflix praktisch zu sein scheint, weil man in einer Vielzahl von Filmen oder Serien vielleicht diese vorgeschlagen bekommt, die einem wirklich gefallen, können diese Vorschläge in sozialen Medien zu der Entstehung von Filterblasen führen. Damit werden Nutzerinnen und Nutzer in den eigenen Ansichten bestätigt und nehmen gegenteilige Sichtweisen weniger wahr. Auch das kann zu Manipulation führen. Auf der Seite des LMZ Baden-Württemberg können mehr Informationen zu Fake News und Filterblasen nachgelesen werden:

Zum Thema Demokratie und KI gibt es weitere Informationen für Interessierte vom Projekt Digitales Deutschland und von der Plattform Lernende Systeme.

Autonome Systeme

Moralische Fragen zu KI-gestützten autonomen Systemen werden schon länger diskutiert, insbesondere für die Automobilindustrie oder im militärischen Sektor. Autonome Fahrzeuge können praktisch sein, wenn nicht genug Personal vorhanden ist, um Menschen von einem Ort zu einem anderen zu bringen, beispielsweise auf dem Land. Bevor dies Realität wird steht aber noch die Beantwortung der Frage aus, wie diese Systeme ethische Entscheidungen treffen sollen, insbesondere in Notfallsituationen. Ein bekanntes Beispiel ist folgendes:

Ein autonomes Fahrzeug fährt auf einer Straße und es versagen die Bremsen. Vor dem Fahrzeug befinden sich auf der einen Seite eine Betonsperre und auf der anderen Seite Menschen. Nun steht das Fahrzeug vor der Wahl, ob es auf die Betonsperre zufährt und damit die möglicherweise tödlichen Folgen für seine Insassen in Kauf nimmt oder einen Unfall mit Fußgängerinnen, Fußgängern oder Tieren verursacht und deren Leben potenziell gefährdet. Weitere Szenarios könnten noch bestimmte Eigenschaften der gefährdeten Personen einbeziehen: Was wäre, wenn der Insasse ein Arzt wäre und der Fußgänger ein Obdachloser? Oder im Auto alte Menschen sitzen und auf der Straße eine Klasse mit Grundschulkindern läuft? Schauen Sie selbst, wie Sie Entscheidungen in einem solchen Dilemma treffen würden mit der Moral Machine des MIT. Auf der Seite können auch Differenzen nach Ländern weltweit verglichen werden. Im Reiter “Über” werden die Ergebnisse einer weltweiten Studie visualisiert. Diese Entscheidungen werfen Fragen nach Moral und rechtlicher Haftung auf: Darüber hinaus müssen Fragen der Privatsphäre und Datensicherheit berücksichtigt werden, da autonome Fahrzeuge eine Vielzahl von Informationen über ihre Umgebung und Insassen sammeln.

Selbstfahrendes Auto (Waymo self-driving car front view), Grendelkhan CC BY SA 4.0 in Wikimedia

Auch im militärischen Bereich gibt es ernsthafte Bedenken zu den moralischen Grundlagen von Entscheidungen der KI. Wenn Waffensysteme ohne menschliche Intervention Ziele identifizieren und angreifen können, wer verantwortet es, wenn diese Systeme Fehler machen. Oder wie kann verhindert werden, dass diese absichtlich missbraucht werden, um Menschenleben zu gefährden. Es ist entscheidend, ethische Richtlinien und Standards zu entwickeln, die sicherstellen, dass diese Technologien im Einklang mit grundlegenden moralischen Prinzipien eingesetzt werden. Mehr zu den rechtlichen Rahmenbedingungen findet sich im letzten Abschnitt.

Arbeitswelt

Eine wesentliche Angst im Zusammenhang mit dem Einsatz von KI ist der Verlust von Arbeitsplätzen. In vielen Bereichen übernehmen KI-gestützte Systeme menschliche Arbeit und werden das in Zukunft noch viel stärker tun. Insbesondere in der Automatisierung liegt eine Nutzung von KI-Systemen nah. Eine Studie aus dem Jahr 2020 ergab, dass nur 6 % der deutschen Unternehmen KI nutzen, und bei diesen wiederum machen KI-gestützte Systeme nur in 12 % der Fälle einen wesentlichen Teil des Geschäfts aus (Quelle: BMWK). Es ist also noch viel Luft nach oben.

Mögliche Anwendungsgebiete sind Tools zur Analyse von Daten in der Produktion oder beim Materialmanagement, in der Kundenbetreuung, der Personalisierung von Werbung oder der Überwachung. Einerseits kann durch intelligente Systeme dem Personalmangel begegnet, Effizienz gesteigert, Fehler reduziert und Ressourcen geschont werden. Auch innerhalb der Tätigkeiten können KI-Systeme unterstützen und die Menschen effektiver machen, sei es beispielweise durch die Nutzung von Large Language Models wie ChatGPT. Auf der anderen Seite besteht die Sorge, dass KI-Systeme Menschen ersetzen würden. Studien zufolge wären bei einem vollumfänglichen Einsatz von KI-Systemen 2/3 der Jobs betroffen und rund 300 Millionen Vollzeitarbeitsplätze könnten durch KI-Systeme ersetzt werden (Quelle). Eine andere Studie aus den USA zeigte, dass LLMs bei 80 % der Beschäftigten etwa 10 % der Arbeitsaufgaben übernehmen können. Teilweise könnte sogar 50 % der Tätigkeiten von LLMs ausgeführt werden. Interessanterweise sind insbesondere Einkommensgruppen mit höheren Lohnniveaus betroffen. Die Autorinnen und Autoren der Studie nennen insbesondere Mathematikerinnen und Mathematiker, Steuerfachleute, Finanzanalystinnen und -analysten, Autorinnen und Autoren sowie Reporterinnen und Reporter und Webdesignerinnen und -designer zu den gefährdeten Berufsgruppen (Quelle). Jedoch entstehen durch jede Innovation auch neue Beschäftigungen und Arbeitsbereiche. Fest steht, dass KI-Systeme einen wachsenden Einfluss auf die Arbeitswelt haben werden, der schwer abzuschätzen ist und stark davon abhängt, wie die Gesellschaft KI-Systeme reguliert, wie Unternehmen den Einsatz bewerten und die Menschen damit umgehen. Wenn ein produktives Team aus KI und Mensch entsteht, kann die Qualität der Arbeit steigen indem sich KI-Systeme und Menschen ergänzen.

Luise Wüstling und KI Makerspace Tübingen, CC BY SA 4.0

Mehr zu den Auswirkungen von KI-Tools auf den Arbeitsmarkt auf der Website der Bundeszentrale für politische Bildung. Außerdem gibt es vom Institut für Arbeitsmarkt- und Berufsforschung einen Job-Futuromat, um den Einfluss von digitalen Technologien auf verschiedene Jobs anzuschauen.